期限が差し迫った学会抄録の作成、たくさんの外来患者の紹介状の作成に時間がかかってしまい、夜遅くまで病院に残って作業をしなければならないという毎日を送っていませんか?毎日のカルテ、紹介状、診断書、学会発表のスライド、論文、患者さんへの説明資料……医師の仕事は「言葉をまとめる作業」にあふれています。診療そのものよりもこのような作業に時間を取られていると感じる方も少なくないでしょう。そんな課題に正面から挑んでいるのが、いま世界で急速に広がるChatGPTをはじめとする生成AIです。ここではChatGPTの使い方を一から紹介していきます。このブログの目的はChatGPTを使ったことがない方が日常臨床でChatGPTを使いこなし、忙しい臨床医の皆様に少しでも時間を節約していただくことです。ぜひChatGPTについて一緒に学んでいきましょう。

1-1: なぜ今、医師はChatGPTを理解すべきか

日本では日常臨床において生成AIの利用はまだまだ進んでいない印象がありますが、すでに海外では、臨床現場での導入が始まっています。『NEJM AI』に掲載された研究では、GPT-4が複雑な臨床ケースの診断能力において医師をはじめとした医学雑誌の読者よりも高い正答率を示したことが報告されています[1]。またシンガポールからの報告ではChatGPTを使用し、カルテの情報をまとめて自動で退院サマリを作成し、重要な要素を正しく取り入れた退院サマリを作成出来たことが報告されました[2]。これらの事例は、AIが単なる“便利な道具”を超えて、”日々の診療を支えるパートナー”になりつつあることを示しています。

一方、日本の状況はどうでしょうか。とある医師調査では「知っているが使ったことがない」あるいは「試した程度」という回答が多数派で、日常診療に本格的に組み込んでいる医師はまだごくわずかでした。つまり私たち日本の医師はAI分野に関して、海外と比べて“まだ大きな伸びしろ”を残している段階にあります。いまAIを学び始めることは先んじて臨床現場をリードする絶好のチャンスといえるでしょう。

実際、ChatGPTは医師の日常業務に直結する多くの領域で力を発揮できます。診療録や紹介状、退院サマリの作成。日常臨床における診断補助や鑑別の整理。文献の検索や要約。医療統計の解析。論文執筆や学会発表の翻訳。さらに患者説明資料の作成や、自身の英語学習まで。まさに「こんな機能があればいいのに」と思っていた領域と、ChatGPTの得意分野は驚くほど重なっています。

もちろん注意も必要です。ChatGPTは事実誤認(ハルシネーション)を起こすことがあり、医学的判断を代替することはできません。だからこそ「どの領域なら安全に活用できるのか」「どのようにリスクを抑えるのか」を理解することが、導入の第一歩になります。海外ではすでにガイドラインが整備されつつあり、日本でも医療分野における生成AI利用指針が示されました。私たち自身が仕組みとリスクを理解し、安全な枠組みをつくることで、ChatGPTは敵か味方か分からない正体不明の存在ではなく、信頼できる相棒となるのです。

本ブログでは、この背景を踏まえ、医師がChatGPTをどう学び、どう実務に取り入れていけばよいのかを、具体的なプロンプト例や事例を交えながら解説していきます。海外の先行事例を紹介しつつ、日本の医療現場に即した応用法を提示することで、「実際の現場でどう使えるのか」が自然とイメージできるようになるはずです。

今一歩踏み出すことで、あなたはAI時代のリーダーとなるでしょう。その第一歩を、この章から始めていきましょう。

参考文献:

[1] Eriksen A, et al. NEJM AI 2024;1(1)

[2] Matthew Chung Yi Koh, et al. BMC Health Services Research. 2025;25:221.

1-2: LLMの超入門~ChatGPTが得意なこと/苦手なこと~

ChatGPTを利用している方も少なくないと思いますが、その仕組みをご存じの方は少ないのではないでしょうか?ChatGPTの中身は「LLM(大規模言語モデル)」と呼ばれる仕組みです。 簡単に言えば、膨大な文章を読み込んで「次に来る言葉を予測する」ことに特化したプログラムです。たとえば「今日は空が…」と入力したら、多くの場合「青い」が続く確率が高いと判断します。もし「今日は空が曇っていて…」と続けば、「雨が降りそう」などが次に来やすくなります。つまりChatGPTは、人間のように「理解」しているわけではなく、言葉の並び方のパターンを学んで確率的に答えを出しているのです。これからもう少し詳しくその仕組みを説明していきます。

ChatGPTの仕組み

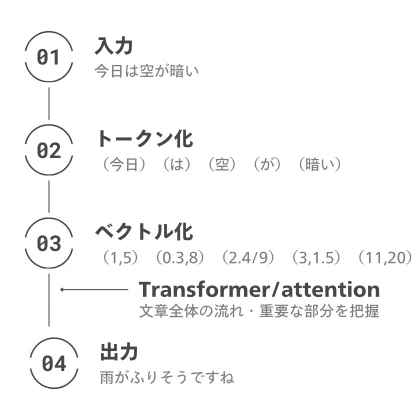

ChatGPTに文章が入力されると、文章はそのままでは扱えないので、まずトークンという単位(単語やサブワード毎)に分解されます。たとえば「心不全」という言葉は「心」「不全」と分けられることもあります。次に、それぞれのトークンは多次元のベクトルに変換され、意味が近いものほど“空間上で近くに配置”されます。たとえば「心不全」と「利尿薬」の位置は近く、「心不全」と「りんご」は遠い、といった具合です。これによりChatGPTは言葉の意味的なつながりを捉えられるようになります。

この「言葉の次を予測する」仕組みを劇的に進化させたのが、Transformerというモデルです。従来のAIは文章を1語ずつ順番に読んで処理していました。Transformerは一度に文章全体を見て、「どの部分が重要か」を計算することができます。たとえば、「胸が痛くなった」という文章では「痛くなった」という言葉が強調されますが、「運動後に胸が痛くなった」という文では「運動後に」が重要になります。この「文章全体を見て重要度を決める」仕組みをAttention(注意機構)と呼びます。この仕組みのおかげでChatGPTは長い文章でも文脈をつかみ、自然な答えを出せるようになったのです。

ChatGPTの中で行われていることは以下のようなイメージになります。

このようにChatGPTは「知識を理解している」のではなく、「膨大な経験からパターンを再現している」のです。そのため、ChatGPTは次のような得意/苦手があります。

- 要約する:長い診療録や治療経過、論文の要点を短くまとめる。文章を指定した文字数にまとめなおす。

- 言い換える:専門的な説明を患者さん向けの分かりやすい言葉に変換する。誤字・脱字を修正する。

- 翻訳する:他言語を分かりやすく翻訳する。

- 整理する:文章を箇条書きや表に整理して見やすくする。

- アイデアを出す:過去の情報、文脈から新しいアイデアを提案する。

- 最新情報を調べる:最新の情報は内臓されておらず、WEB検索機能で調べて出力するため、正確でないことがある。

- 判断する:理解している訳ではないため、情報の正確性などを判断することは出来ない。

- 画像・図表の生成:グラフや図などの生成は出来るが、正確でないことがある。

このようにChatGPTは「膨大な経験からパターンを再現し、次の言葉を予測する」という、とてもシンプルな原理で動いています。そのため、ChatGPTが得意な分野においてはその能力は人間を大きく上回ります。ただし万能ではなく、事実確認や最終的な判断は必ず人間が行う必要があります。特に倫理的な判断や患者さんそれぞれに対して適切な治療選択を行うことは困難です。ChatGPTの仕組みを正しく理解し、得意分野をうまく活用していきましょう。

1-3: ChatGPT使用における注意点と医療安全~AI利用ガイドラインに基づくリスク管理~

先ほど説明したように、ChatGPTは医療現場の業務効率を飛躍的に高める可能性を秘めています。しかし同時に、「誤情報の生成(ハルシネーション)」や「個人情報の流出」、「法的責任の所在」といった、生成AI特有の新たなリスクも伴います。どれほどAIの精度が高くても、最終的な判断と責任は常に私たち人間にあります。ChatGPTを活用する際に思わぬトラブルに巻き込まれないよう、本章では生成AI利用時のリスクと安全に使用するための対策について、医療AI利用ガイドラインに基づいて解説します。

ChatGPT使用の際の注意点

非営利法人 医療AIプラットフォーム技術研究組合による「医療・ヘルスケア分野における生成AI利用ガイドライン(第2版)」では、医療で生成AIを用いる際の主なリスクとして以下が挙げられています(一部を抜粋)。

- 正確性・信頼性:誤情報を含めたアウトプットを生成する。

- バイアス・公平性:学習データの偏りによるバイアスや不公平な出力。

- 著作権侵害:他者の文章や画像を無断で引用する可能性。

- プライバシー侵害:情報漏えいや個人情報保護法への違反に繋がってしまう。

- セキュリティリスク:不正な操作・攻撃等が行われた際に、情報漏えいや改ざん等が発生する。

これらはいずれも、医療現場における信頼と安全に直結する重大な問題です。だからこそ、AIを「リスクを伴う技術」として正しく理解することが求められます。次に特に個人利用の際に特に注意すべき内容について個別に解説していきます。

事実誤認(ハルシネーション)

ChatGPTは大量の文章データを学習し、「次に来る言葉を確率的に予測する」仕組みで動作します。そのため、文脈上は自然でも事実と異なる情報をもっともらしく生成することがあります。これを「ハルシネーション」と呼びます。例えば存在しない論文を引用したり、事実と異なる病歴を自動的に追加したりするケースが報告されています。

ハルシネーションに対する対策としては以下が重要になります。

- プロンプト(命令)入力の際に出典元を明示するように指示する。

- 出力された内容を必ず自らが確認する。

誤った情報を診療に利用することの責任は医師にあります。ハルシネーションの可能性を念頭に置き、ChatGPTを利用するようにしましょう。

個人情報の取り扱いと情報漏洩

次に注意すべきは、個人情報や診療データの扱いです。多くのAIサービスでは、入力内容が再学習に利用される設定になっています。このため、入力した患者情報がサーバーに保存・転送される可能性があります。個人情報の漏洩は起こってはならない重要な問題です。

個人情報の取り扱いについて

- 個人情報は匿名化してから入力するようにする。

- ChatGPTに送った情報を利用させない(オプトアウト)設定に変更する。

オプトアウト設定についてはのちほど説明しますが、入力時には必ず患者氏名やIDなどを削除し、匿名化または仮名化すること。「入力する情報は、外部に出ても問題がない範囲に限定する」-この意識を持つだけで、多くのリスクを防ぐことができます。個人情報の扱いには十分に注意しましょう。

法令順守と説明責任

ChatGPTによって作成された診療録や報告書に誤りがあった場合、医師法・医療法・薬機法などに抵触するおそれがあります。どれほどChatGPTが優れていても、最終確認と責任は医師にあるという原則は変わりません。また、AIで作成した文書を患者や他院に提供する際は「AIを利用して作成したこと」や「医師が最終確認を行ったこと」を明示することで、

透明性と信頼性を確保できます。説明責任を果たすことが、医療への信頼を守る最善の方法です。

まとめ

ChatGPTは臨床医の仕事を助ける非常に強力なツールです。一方で、誤情報・情報漏えい・法的責任といったリスクも避けて通れません。上記のルールを守りながら、安全にChatGPTを使用していきましょう。使用に際しては一度ガイドラインに目を通しておくのがよいかもしれません。

第2章からは、実際の使い方と具体的な活用法について解説していきます。

コメント